Robots.txt یک فایل متنی فرمت txt است که به منظور ایجاد دستورالعملهایی برای سطح دسترسی به رباتهای گوگل تا به آنها بفهمانند که چگونه صفحات را در وبسایت خود پیدا کنند. حالا دقیقا منظور از این فایل متنی Robots.txt چیست؟

تصور کنید که به یک شهر جدید مهاجرت کردهاید و بهمحض ورود شما همانند اهالی بومی آنجا نمیدانید بهترین رستوران آن کجاست، در آن محله برای خرید باید به کدام فروشگاه بروید. حالا مسئولان شهر برای آشنایی افرادی همانند شما یک اطلاعات کلی از این شهر بهمحض ورود با انتشار کارتکس یا هر چیز دیگری در اختیار شما قرار میدهند. فایل Robots.txt در سئو تکنیکال نقش مهمی را ایفا میکند.

دقیقا فایل Robots.txt به همین منظور ایجاد میشود و نقش یک راهنما را برای کراولرهای گوگل بازی میکنند و به آنها میگویند که به کدام آدرس بروند و از کدامشان هم رد شوند.

فایل robots.txt بخشی از پروتکل حذف رباتها (REP) است، گروهی از استانداردهای وب که نحوه پیمایش آنها در وب، دسترسی و فهرستبندی محتوا و ارائه آن محتوا به کاربران را تنظیم میکند.

REP شامل دستورالعملهایی برای رباتهای متا که نحوه برخورد موتورهای جستجو با کل سایت و لینکها (مانند «follow» یا «nofollow») را مشخص میکنند.

در این مطلب از آکادمی سئو پورفیض به چند موضوع مهم اشاره کردهایم:

- robots.txt چگونه کار میکند؟

- robots.txt در یک سایت کجا می رود؟

- چرا به robots.txt نیاز دارید؟

- بررسی اینکه آیا فایل robots.txt دارید یا خیر؟

- نکات سئوی robots.txt

- Robots.txt در مقابل متا رباتها و رباتهای x

فایل robots.txt چیست؟

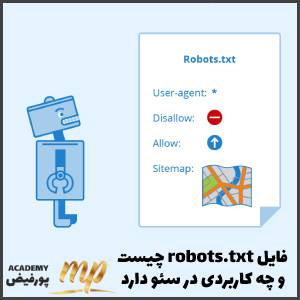

در عمل، فایل robots.txt نشان میدهد که آیا کراولرها یا خزندههای گوگل میتوانند یا نمیتوانند بخشهایی از یک وبسایت خزش کنند. این دستورالعملهای خزیدن با «اجازه ندادن disallowing» یا «اجازه دادن، allowing» به قسمتی از سایت بر اساس آدرس، در فایل robots.txt مشخص میشود.

به طور خلاصه باید گفت که Robots.txt فایلی است که به عنکبوتهای موتورهای جستجو میگوید که صفحات یا بخشهای خاصی از یک وبسایت را مرور و دنبال نکنند. اکثر موتورهای جستجوی اصلی (از جمله گوگل، بینگ و یاهو) درخواستهای Robots.txt را میشناسند و به آنها احترام میگذارند. فایل Robots.txt میتواند به بهینه سازی نرخ خزش یا crawl budget سایت ما کمک زیادی کند.

فایل robots.txt چگونه کار میکند؟

موتورهای جستجو دو کار اصلی دارند:

- خزیدن در وب برای درک محتوا.

- بررسی و رتبه بندی آن محتوا به گونهای که بتوان آن را برای جستجوگرانی که به دنبال اطلاعات هستند، ارائه کرد.

برای خزیدن در سایتها، موتورهای جستجو لینک را دنبال میکنند تا از یک سایت به سایت دیگر برسند، در نهایت، در میان میلیاردها لینک و وبسایت میخزند. این رفتار خزیدن یا کراولینگ بعضی اوقات با عنوان “عنکبوت یا spidering” شناخته میشود.

همه چیز درباره الگوریتم bert

خزنده جستجو پس از رسیدن به یک وب سایت، قبل از spider کردن آن، به دنبال فایل robots.txt میگردد. اگر یکی را پیدا کرد، خزنده قبل از ادامه صفحه ابتدا آن فایل را میخواند. از آنجایی که فایل robots.txt حاوی اطلاعاتی در مورد نحوه خزیدن موتور جستجو است، اطلاعاتی که در آنجا یافت میشود، باقی اقدامات خزنده را در این سایت خاص راهنمایی میکند.

اگر فایل robots.txt حاوی دستورالعملهایی نباشد که فعالیت یک کاربر را ممنوع کند (یا اگر سایت فایل robots.txt نداشته باشد)، به خزیدن اطلاعات دیگر در سایت ادامه میدهد.

سایر اطلاعاتی که درباره فایل robots.txt باید بدانید:

- Robots.txt به حروف کوچک و بزرگ حساس است، نام فایل باید “robots.txt” باشد (نه Robots.txt، robots.TXT یا غیره).

- برخی از رباتها ممکن است فایل robots.txt شما را نادیده بگیرند. این امر به ویژه در مورد خزندههای بدجنس مانند رباتهای بدافزار رایج است.

- فایل robots.txt خیلی راحت در دسترس شماست، فقط کافیست /robots.txt را به انتهای دامنه اصلی اضافه کنید تا دستورالعملهای آن را در وب سایت ببینید (اگر آن سایت دارای فایل robots.txt باشد!). این بدان معناست که هر کسی میتواند ببیند شما چه صفحاتی را نشان میدهید یا نمیخواهید کدام صفحات خزیده شوند.

- هر زیر دامنه در یک دامنه اصلی،از فایلهای جداگانه robots.txt استفاده میکند. این بدان معناست که هر دو blog.example.com و example.com باید فایلهای robots.txt خود را داشته باشند (در blog.example.com/robots.txt و example.com/robots.txt).

چرا فایل Robots.txt مهم است؟

اکثر وبسایتها به دستورالعملهای خاصی در فایل robots.txt نیاز ندارند. به این دلیل است که گوگل معمولاً میتواند تمام صفحات مهم سایت شما را پیدا و فهرست کند. آنها به طور خودکار صفحاتی را که مهم نیستند یا نسخههای تکراری باشند را ایندکس نمیکنند. با این حال، ۳ دلیل اصلی زیر را باید برای استفاده از از فایل robots.txt داشته باشید.

- مسدود کردن صفحات غیر عمومی: گاهی اوقات صفحاتی در سایت خود دارید که نمیخواهید ایندکس شوند. برای مثال، ممکن است یک نسخه مرحلهبندی از یک صفحه داشته باشید، یا یک صفحه برای ورود این صفحات باید وجود داشته باشند. اما شما نمیخواهید در میان ترافیکهای ارگانیک و به صورت تصادفی کاربران آنجا فرود آیند. این موردی است که از robots.txt برای مسدود کردن این صفحات از خزندهها و رباتهای موتور جستجو استفاده میکنید.

- به حداکثر رساندن باجت خزیدن: اگر برای ایندکس شدن همه صفحات خود با مشکل مواجه هستید، ممکن است با مشکل باجت خزیدن مواجه شوید. با غیرفعال کردن صفحات کماهمیت با robots.txt، Googlebot میتوانید بیشتر سهم کراول کردن را صرف صفحاتی کنید که واقعاً برایتان مهم هستند.

- جلوگیری از نمایهسازی منابع: استفاده از دستورات متا ایده خوبی برای استفاده از Robots.txt جهت جلوگیری کردن از ایندکس شدن صفحات است. با این حال، دستورالعملهای متا برای منابع چندرسانهای مانند فایلهای PDF و تصاویر، به خوبی کار نمیکنند. اینجاست که robots.txt وارد عمل میشود.

زبان فایلهای Robots.txt

پنج اصطلاح رایج در این زمینه وجود دارد که احتمالاً در فایل رباتها با آنها روبرو خواهید شد. آنها عبارتند از:

- عامل کاربر: خزنده وب خاصی که دستورالعملهای خزیدن را به آن میدهید (معمولاً یک موتور جستجو). لیستی از اکثر عوامل کاربر را میتوان در اینجا یافت.

- Disallow: دستوری که به یک user-agent میگوید URL خاص را نخزد. فقط یک خط و صدور عدم اجازه برای هر URL مجاز است.

- Allow (فقط برای Googlebot قابل اجراست): دستوری که به Googlebot اعلام میکند، میتواند به یک صفحه دسترسی داشته باشد، حتی اگر صفحه اصلی آن غیرمجاز باشد.

- Crawl-Delay: یک خزنده چند ثانیه باید قبل از بارگیری و خزیدن محتوای صفحه منتظر بماند. توجه داشته باشید که Googlebot این دستور را تایید نمیکند، اما نرخ خزیدن را میتوان در کنسول جستجوی گوگل تنظیم کرد.

- سایت مپ: پیادهسازی سایت یا نقشههای سایت XML با این URL انجام میشود. توجه داشته باشید که این دستور تنها توسط Google، Ask، Bing و Yahoo پشتیبانی میشود. برخی از سایتها مستقیما در فایل robots.txt، یک دستورالعمل ایجاد میکنند که خزندهها سایت مپ آنها را نیز مرور کنند.

تطبیق الگوهای Robots.txt چیست

وقتی صحبت از URLهای واقعی برای مسدود کردن یا مجاز شدن میشود، فایلهای robots.txt میتوانند نسبتاً پیچیده شوند، زیرا امکان استفاده از تطبیق الگو را برای پوشش طیف وسیعی از گزینههای URL ممکن میکند.

گوگل و بینگ هر دو از دو عبارت منظم استفاده میکنند که میتوانند برای شناسایی صفحات یا زیرپوشههایی که یک SEO میخواهد حذف کند، استفاده شوند. این دو کاراکتر و علامت ستاره (*) و دلار ($) هستند.

robots.txt در یک سایت کجا میرود؟

موتورهای جستجو و سایر رباتهای خزنده وب (مانند خزنده Facebot) هر زمان که به سایتی مراجعه میکنند، میدانند که باید به دنبال فایل robots.txt بگردند.

اما، آنها فقط آن فایل را در یک مکان خاص جستجو میکنند، دایرکتوری اصلی (معمولاً دامنه اصلی یا صفحه اصلی شما).

اگر یک عامل کاربر از www.example.com/robots.txt بازدید کند و فایل رباتی را در آنجا پیدا نکند، فرض میکند که سایت فایلی ندارد و به خزیدن همه چیز در صفحه (و شاید حتی در کل سایت) ادامه میدهد. حتی اگر صفحه robots.txt مثلاً در example.com/index/robots.txt یا www.example.com/homepage/robots.txt وجود داشته باشد، توسط عوامل کاربر کشف نمیشود و در نتیجه سایت مورد بررسی قرار میگیرد. گویا اصلا فایل رباتی نداشت. برای اطمینان از یافتن فایل robots.txt، همیشه آن را در فهرست اصلی یا دامنه اصلی خود قرار دهید.

چرا به robots.txt نیاز دارید؟

فایلهای Robots.txt دسترسی خزنده به مناطق خاصی از سایت شما را کنترل میکنند. در حالی که اگر شما به طور تصادفی Googlebot را از خزیدن در کل سایت خود منع کنید، میتواند بسیار خطرناک باشد، مواردی وجود دارند که فایل robots.txt میتواند در آنها بسیار مفید باشد.

برخی از موارد استفاده رایج عبارتند از:

-

- جلوگیری از ظاهر شدن محتوای تکراری در SERP (توجه داشته باشید که متا رباتها اغلب انتخاب بهتری برای این کار هستند).

- خصوصی نگه داشتن بخشهای کامل یک وب سایت (به عنوان مثال، سایت مرحلهبندی تیم مهندسی شما).

- جلوگیری از نمایش داده شدن صفحات نتایج جستجوی داخلی در SERP عمومی.

- تعیین سایت مپ.

- جلوگیری از ایندکس کردن فایلهای خاص در وب سایت شما (تصاویر، PDF و غیره) توسط موتورهای جستجو.

- تعیین تأخیر خزیدن به منظور جلوگیری از بارگیری بیش از حد سرورهای شما هنگام بارگیری همزمان چند قطعه محتوا توسط خزندهها.

این نکته حائز اهمیت است که اگر هیچ بخشی در سایت شما وجود ندارد که بخواهید دسترسی عامل کاربر به آن را کنترل کنید، ممکن است اصلاً به فایل robots.txt نیاز نداشته باشید.

Robots.txt به عنکبوتهای موتورهای جستجو میگوید که صفحات خاصی را در وبسایت شما نخزند. میتوانید بررسی کنید که چند صفحه را در کنسول جستجوی گوگل ایندکس کردهاید. اگر با تعداد صفحاتی که میخواهید ایندکس شوند مطابقت دارد، نیازی به ایجاد فایل Robots.txt ندارید. اما اگر این تعداد بیشتر از چیزی است که انتظار داشتید (و متوجه URLهای که بدون درخواست شما تبدیل به صفحه شده و شما از آنها بیخبر هستید)، وقت آن است که یک فایل robots.txt برای وب سایت خود ایجاد کنید.

بررسی اینکه آیا فایل robots.txt دارید یا خیر

مطمئن نیستید که فایل robots.txt دارید یا نه؟ به سادگی دامنه اصلی خود را تایپ کنید، سپس /robots.txt را به انتهای URL اضافه کنید. اگر صفحه txt. نمایش داده نشد، در حال حاضر صفحه robots.txt ندارید.

نکات مهم سئوی robots.txt

- اطمینان حاصل کنید که هیچ محتوا یا بخشی از وبسایت خود را که میخواهید خزیده شود،مسدود نمیکنید. همانطور که گفته شد لینکهای موجود در صفحات مسدود شده توسط robots.txt دنبال نمیشوند.

مگر اینکه از دیگر صفحات قابل دسترسی موتور جستجو (به عنوان مثال صفحاتی که از طریق robots.txt، رباتهای متا یا موارد دیگر مسدود نشدهاند) لینک داده شده باشند، منابع لینک داده شده مرور و ممکن است ایندکس نشوند. ارزش هیچ لینکی را نمیتوان از صفحه مسدود شده به مقصد دیگر منتقل کرد.

- از robots.txt برای جلوگیری از نمایش دادههای حساس (مانند اطلاعات خصوصی کاربر) در نتایج SERP استفاده نکنید. از آنجا که صفحات دیگر ممکن است مستقیماً به صفحه حاوی اطلاعات خصوصی لینک شوند (در نتیجه دستورالعملهای robots.txt در دامنه اصلی یا صفحه اصلی شما را دور میزنند)، ممکن است همچنان ایندکس شود.

اگر میخواهید صفحه مورد نظر از نتایج جستجو مسدود شود، از روش دیگری مانند محافظت با رمز عبور یا دستورالعمل متا noindex استفاده کنید.

- برخی از موتورهای جستجو دارای چندین عامل کاربر هستند. به عنوان مثال، Google از Googlebot برای جستجوی ارگانیک و از Googlebot-Image برای جستجوی تصویر استفاده میکند.

اکثر عوامل کاربر یک موتور جستجو از قوانین یکسانی پیروی میکنند، بنابراین نیازی به تعیین دستورالعمل برای هر یک از خزندههای متعدد موتور جستجو نیست، اما توانایی انجام این کار را به شما میدهد که نحوه خزیدن محتوای سایت خود را دقیق تنظیم کنید.

- یک موتور جستجو محتویات robots.txt را در حافظه پنهان میکند، اما معمولاً حداقل یک بار در روز مطالب ذخیره شده را آپدیت میکند. اگر فایل را تغییر میدهید و میخواهید آن را سریعتر از آنچه اتفاق میافتد بهروزرسانی کنید، میتوانید نشانی اینترنتی robots.txt خود را به Google ارسال کنید.

نکته مهم: فایل robots.txt را از طریق روت اصلی هاست سایت اعمال میشود. در سیستم مدیریت محتوایی وردپرس این فایل بهطور پیشفرض تعریف شده است.

Robots.txt در مقابل متا رباتها و رباتهای x

تفاوت بین این سه نوع دستورالعمل ربات چیست؟ اول از همه، robots.txt یک فایل متنی واقعی است، در حالی که متا و رباتهای x دستورات متا هستند.

فراتر از آنچه که به نظر میرسند، هر سه عملکردهای متفاوتی دارند. Robots.txt رفتار خزیدن در کل سایت یا دایرکتوری را دیکته میکند، در حالی که رباتهای متا و x میتوانند نحوه رفتار نمایهسازی و فهرستبندی در یک سایت را مشخص کنند.

خلاصه و جمع بندی Robots.txt

یک فایل robots.txt به خزندههای موتورهای جستجو میگوید که به کدام URLها میتواند در سایت شما دسترسی داشته باشد. این عمدتا برای جلوگیری از بارگذاری بیش از حد سایت شما توسط کروالرهای گوگل صورت میگیرد.

هیچ مکانیسمی برای آنکه گوگل صفحات شما را نبیند، به طور خودکار وجود ندارد. بلکه برای دور نگه داشتن یک صفحه وب از Google، با noindex مسدود یا صفحه را با رمز عبور محافظت میکنید.

توجه داشته باشید که دستورات robots.txt ممکن است توسط همه موتورهای جستجو پشتیبانی نشود. دستورالعملهای موجود در فایلهای robots.txt نمیتوانند رفتار خزنده را در سایت شما اعمال کنند.

این به خزنده بستگی دارد که از آنها پیروی کند. در حالی که Googlebot و سایر خزندههای وب معتبر از دستورالعملهای فایل robots.txt پیروی میکنند، خزندههای دیگر ممکن است این کار را انجام ندهند.

اگر میخواهید اطلاعات را از خزندههای وب ایمن نگه دارید، بهتر است از روشهای مسدودسازی دیگر مانند محافظت از فایلهای خصوصی با رمز عبور روی سرور خود استفاده کنید. امیدوارم که با خواندن این صفحه از آکادمی سئو پورفیض به صورت دقیق متوجه شده باشید که فایل robots.txt چیست.